Report 20250818

论文:GSLI

title: GSLI: Graph Structure Learning for Spatial-Temporal Imputation: Adapting to Node and Feature Scales

创新点

-

多尺度图结构学习:动态适配异质空间相关性

- 现有方法通常依赖固定空间图,并假设所有特征的空间关系在不同位置是一致的,但论文指出,不同特征在不同节点的空间相关性存在显著差异(特征异质性),且同一节点内的不同特征间存在潜在共性关联(特征间共性)

- 节点尺度图结构学习:为每个特征独立学习全局空间图,捕捉不同特征的专属空间相关性,避免跨特征干扰

- 特征尺度图结构学习:对于每个节点,学习其内部的特征空间之间的空间图,补充固定图未覆盖的特征间依赖

-

显著性建模:增强关键节点与关键特征的权重

- 现有方法在图结构学习中通常对所有节点和特征赋予同等权重,忽略了它们对补全任务的贡献差异(如数据完整度高的节点、与缺失值强相关的特征更重要)

- 在节点尺度:通过 MLP 学习节点显著性向量,增强对补全更重要的节点在图中的权重(如数据完整的节点对缺失值的参考价值更高)

- 在特征尺度:通过 MLP 学习特征显著性向量,突出对补全贡献更大的特征(如与缺失特征强相关的特征权重更高)

-

跨特征与跨时间表示学习的深度融合

-

现有方法往往单独处理空间依赖或时间依赖,且难以捕捉高维度的跨节点 - 特征关联(如节点 A 的特征 1 与节点 B 的特征 2 的关联)

-

跨特征表示学习:基于 Transformer 自注意力机制,整合节点尺度和特征尺度的空间信息,建模高维度(N \times F)^2的跨节点 - 特征依赖,解决传统方法无法覆盖的复杂空间关联

-

跨时间表示学习:基于原始观测信号学习时序依赖,为空间建模提供时序上下文,并避免因数据缺失导致的时间模式失真

-

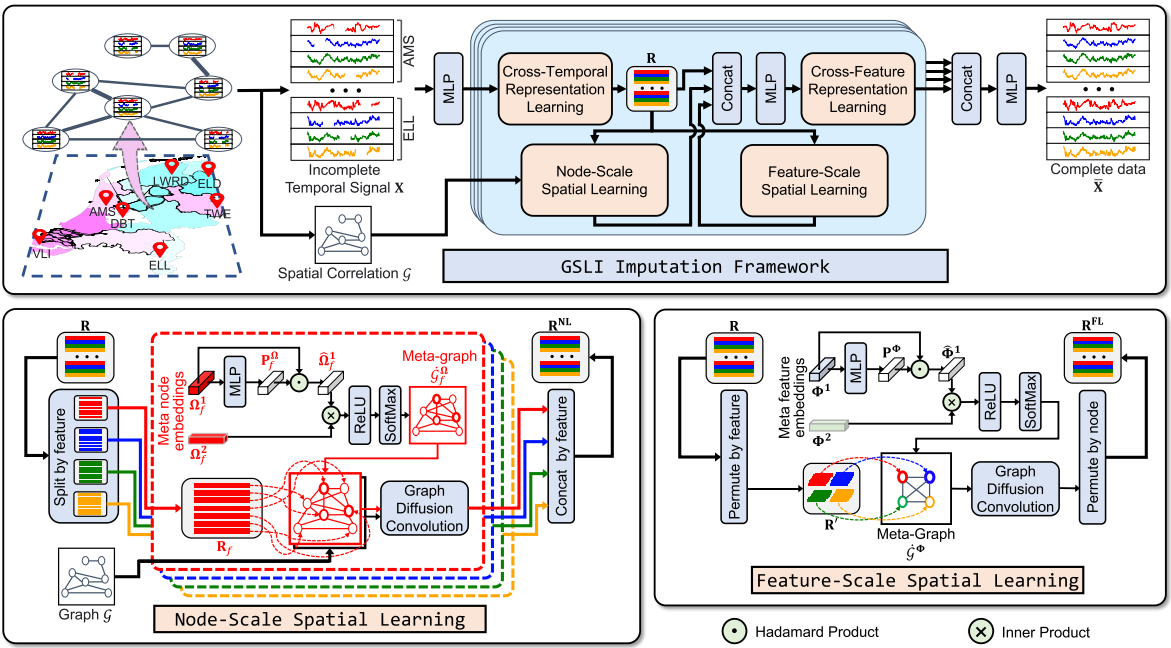

模块构成

-

跨时间表示学习:Cross-Temporal Representation Learning

- 目标:捕捉时序依赖(如历史数据对当前缺失值的影响),为补全提供时间维度的信息支撑

- 构成:

- 输入:原始时空信号X^I(含缺失值的观测数据);

-

关键模块:深层投影、时间拆分、Transformer 自注意力机制

-

步骤:

- 深层投影:通过 MLP 将原始信号X^I投影到深层空间,得到H\in\mathbb{R}^{N\times T\times F\times C}

- 节点 - 特征拆分:将 H 按节点和特征拆分为N \times F个片段H_y\in \mathbb{R}^{T\times C}(每个片段对应一个节点 - 特征对的时序信号)

- 自注意力学习:利用 Transformer 的自注意力机制捕捉每个节点 - 特征对的时序依赖:R_y=\mathrm{SoftMax}(\frac{Q_y K_y^\top}{\sqrt{C}})V_y,其中Q_y=H_yW_Q^{CT},K_y=H_yW_K^{CT},V_y=H_yW_V^{CT}

-

输出整合:拼接所有R_y并按节点维度展平,得到跨时间表示R\in\mathbb{R}^{N\times T\times F\times C}(作为节点 / 特征尺度学习的输入)

-

作用

- 基于原始观测信号学习时序依赖,避免因数据缺失导致的时间模式失真

- 为空间依赖建模提供时序上下文,提升补全的时间一致性

- 节点尺度空间学习:Node-scale Spatial Learning

- 目标:将不同特征分开,分别学习每种特征的全局空间相关性

- 构成:

- 输入:深层空间表示R\in \mathbb{R}^{N\times T\times F\times C}(N节点数,T时间戳,F特征数,C特征表示的通道数)

- 关键模块:特征拆分、元节点嵌入、显著性建模、元图构建、图扩散卷积

- 步骤:

- 特征拆分:R\in \mathbb{R}^{N\times T\times F\times C}按照特征维度拆分,每个特征对应R_f\in \mathbb{R}^{N\times T\times C}

- 元节点嵌入: 对于每个特征R_f,分配两个元节点嵌入\Omega_f^1\in\mathbb{R}^{N\times d},\Omega_f^2\in\mathbb{R}^{d\times N},(实验中d取10),\Omega_f^1为源节点嵌入,\Omega_f^2为目标节点嵌入,用于建模节点间的潜在关联

- 显著性建模:通过多层感知机学习节点间显著性向量P_f^\Omega=\mathrm{MLP}((\Omega_f^1)^\top)^\top,通过Hadamard积优化源节点嵌入:\hat{\Omega}_f^1=\Omega_f^1 \odot P_f^\Omega,增强对补全更重要的节点权重

- 元图构建:优化后的源节点嵌入与目标嵌入的内积,结合ReLU(负半轴输出全为0,过滤弱关联)和softmax归一化生成特征f的元图邻接矩阵:\dot{A}_f^\Omega=\mathrm{SoftMax}[\mathrm{ReLU}(\hat{\Omega}_f^1\Omega_f^2)]

- 图扩散卷积:结合原始图G的邻接矩阵A和元图\dot{G}_f^\Omega的邻接矩阵\dot{A}_f^\Omega,通过图扩散卷积捕捉特征f的空间依赖:R_f^{NL}=\sum_{k=0}^K[\dot{A}_f^\Omega R_f \Theta_{k,f}^{\Omega1}+(D^{O-1}A)^kR_f \Theta_{k,f}^{\Omega2}+(D^{I-1}A^\top)^kR_f \Theta_{k,f}^{\Omega3}],其中K为扩散步数,\Theta为卷积核,D^O/D^I为出/入度矩阵(第一项用于解决特征异质性,第二项捕捉当前节点向外扩散的依赖(自身对外的影响),第三项捕捉向当前节点汇聚的依赖(外界对自身的影响))(实验中K取2)

- 输出拼接:将所有特征的R_f^{NL}拼接为节点尺度学习的输出R^{NL}\in\mathbb{R}^{N\times T\times F\times C}

- 作用:

- 为每个特征独立学习全局空间图结构,避免不同领域特征(如风速与风向)的空间关系相互干扰

- 通过显著性建模突出关键节点的影响,提升空间依赖建模的精准度

- 特征尺度空间学习:Feature-scale Spatial Learning

- 目标:挖掘 “节点内特征共性”(同一节点中不同特征的空间关联),学习所有节点上特征间的共同空间相关性

-

构成:

- 输入:同节点尺度学习的输入R

- 关键模块:元特征嵌入、特征显著性建模、元图构建、图扩散卷积、维度置换

-

步骤:

- 元特征嵌入:定义两个可学习的元特征嵌入\Phi^1\in\mathbb{R}^{F\times d},\Phi^2\in\mathbb{R}^{d\times F},(实验中d取10)第一个为源特征嵌入,第二个为目标特征嵌入),用于建模特征间的潜在关联

- 特征显著性建模:通过 MLP 学习特征显著性向量P^\Phi=\mathrm{MLP}((\Phi^1)^\top)^\top,优化源嵌入:\hat{\Phi}^1=\Phi^1\odot P^\Phi,增强对补全更重要的特征权重

- 元图构建:通过优化后的源特征嵌入和目标特征嵌入的内积,生成特征间的元图邻接矩阵:\dot{A}^\Phi=\mathrm{SoftMax}[\mathrm{ReLU}(\hat{\Phi}^1\Phi^2)]

- 维度置换与卷积:将输入R置换为R'\in\mathbb{R}^{F\times N\times T\times C},通过基于\dot{A}^\Phi的图扩散卷积捕捉特征间依赖:R'^{FL}=\sum_{k=0}^K\dot{A}^\Phi R'\Phi_k^\Phi(实验中K取2)

- 输出置换:将R'^{FL}置换回原始维度,得到特征尺度学习的输出R^{FL}\in\mathbb{R}^{N\times T\times F\times C}

-

作用

- 捕捉同一节点内不同特征的空间关联(如温度与湿度的相关性),补充固定空间图无法覆盖的特征间依赖

- 通过特征显著性建模突出关键特征的影响,提升特征关联建模的有效性

- 跨特征表示学习:Cross-Feature Representation Learning

- 目标:整合节点尺度和特征尺度的空间信息,捕捉不同节点间特征的复杂空间依赖(如节点 A 的特征 1 与节点 B 的特征 2 的关联)

-

构成

- 输入:原始表示R、节点尺度输出R^{NL}、特征尺度输出R^{FL}

- 关键模块:特征拼接与融合、Transformer 自注意力机制

-

步骤

- 特征融合:将R,R^{NL},R^{FL}按特征维度拼接,通过 MLP 融合为E\in\mathbb{R}^{N\times T\times F\times C}

- 时间拆分与维度合并:将E按时间戳拆分为T个片段E_t\in\mathbb{R}^{(N\times F)\times C}(合并节点与特征维度)

- 自注意力学习:利用 Transformer 的自注意力机制捕捉每个时间戳内的跨特征 - 节点依赖:Z_t=\mathrm{SoftMax}(\frac{Q_t K_t^\top}{\sqrt{C}})V_t,其中Q_t=E_tW_Q^CF,K_T=E_TW_K^CF,V_T=E_TW_V^CF

- 输出整合:将各时间戳的Z_t拼接为跨特征表示Z\in\mathbb{R}^{N\times T\times F\times C}

-

作用

- 建模高维度(N\times F)^2的空间依赖,解决节点 / 特征尺度学习无法覆盖的跨节点 - 特征关联

- 整合多尺度空间信息,增强模型对复杂空间模式的捕捉能力

实验部分

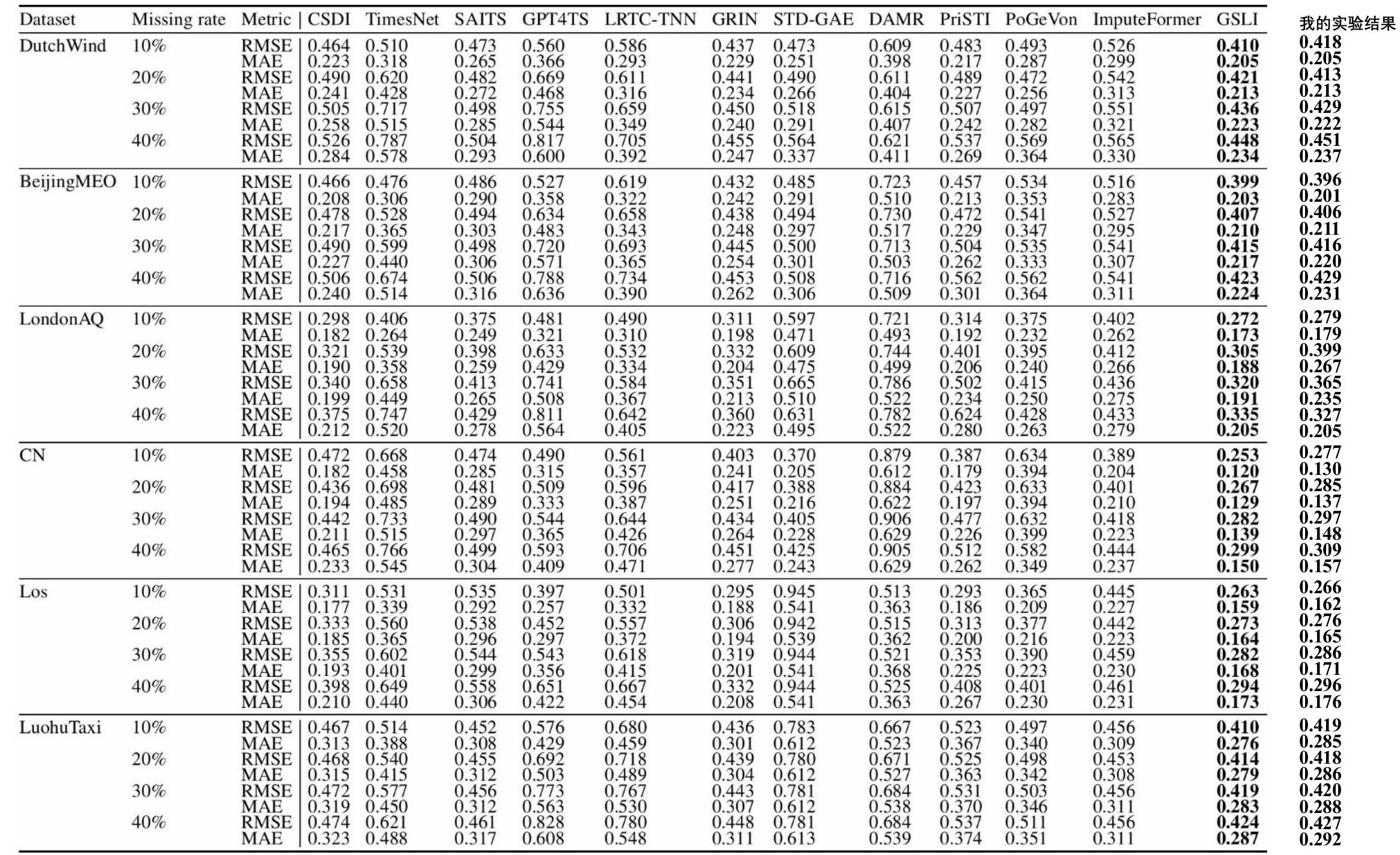

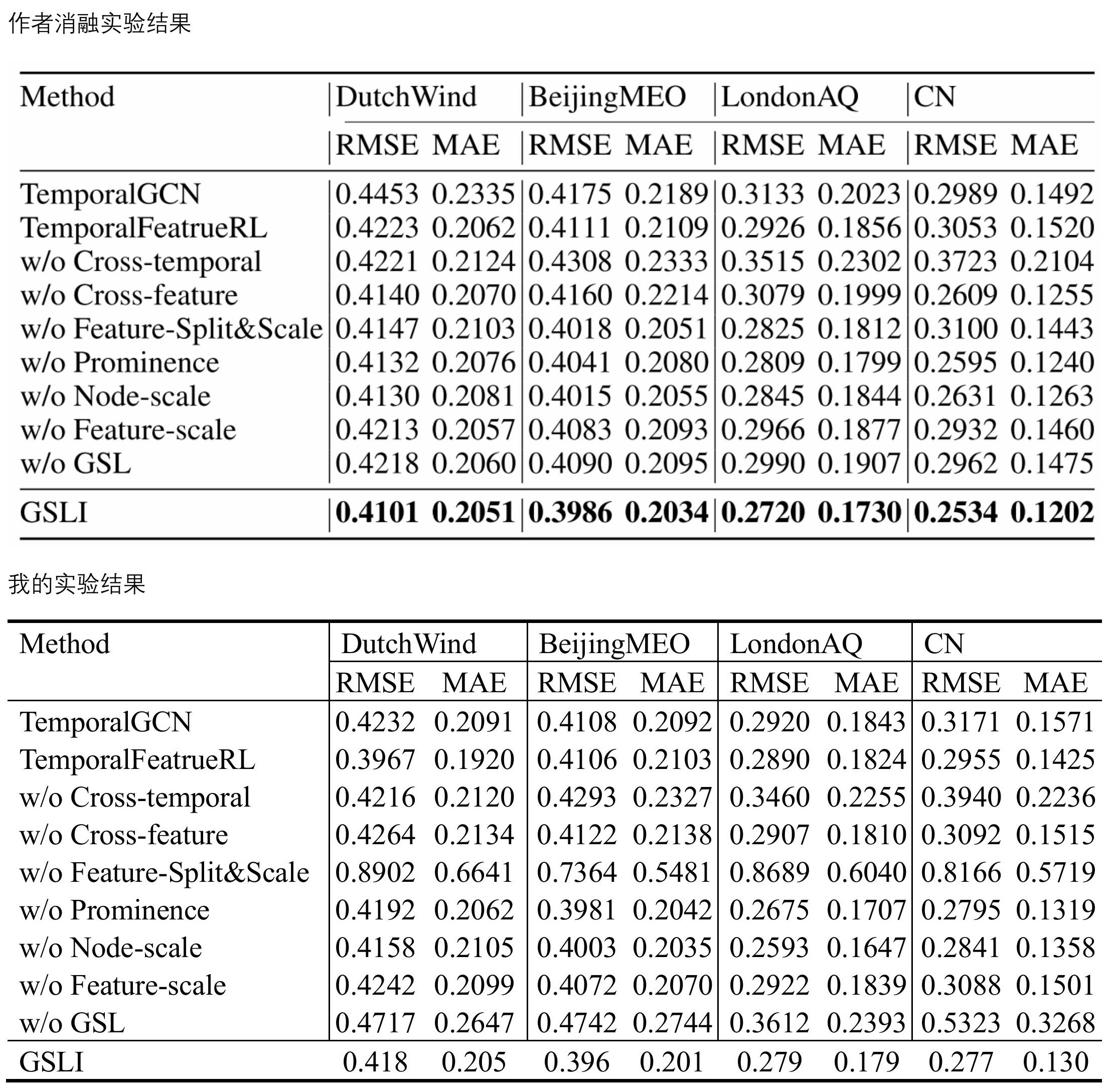

实验结果复现: